Cada vez que usted, su familia o amigos cargan una foto o video en una plataforma de redes sociales, los algoritmos de reconocimiento facial aprenden más sobre quién es usted, a quién conoce y dónde se encuentra.

Para tener en cuenta las preocupaciones de privacidad de las personas, los investigadores de la Universidad de Toronto (U of T) han desarrollado un algoritmo que puede interrumpir los sistemas de reconocimiento facial y prohibir que los sistemas aprendan más sobre usted.

El estudio completo, que explica el algoritmo, está disponible esta página.

"Somos capaces de engañar a una clase de algoritmos de detección de rostros de vanguardia atacándolos de manera adversa", dijo Avishek Bose, un estudiante graduado en el Departamento de Electricidad y

Ingeniería Informática en U de T y coautor del estudio.

"La privacidad personal es un problema real a medida que el reconocimiento facial se vuelve cada vez mejor" Parham Aarabi, profesor asociado en el Departamento de Ingeniería Eléctrica e Informática de la U de T y coautor del estudio, dijo en un comunicado. "Esta es una forma en que los sistemas beneficiosos de reconocimiento anti-facial pueden combatir esa capacidad".

La técnica

La solución del equipo consiste en hacer que dos algoritmos de inteligencia artificial, un detector facial y un generador de adversarios compitan entre sí, explicó Bose.

El detector de rostros trabaja para identificar rostros, y el generador adversarial funciona completamente para interrumpir el detector de rostros.

"El detector de rostros no tiene conocimiento de la existencia del generador de adversarios, mientras que el generador aprende con el tiempo cómo engañar con éxito al detector", dijo Bose. "Inicialmente, el generador es muy malo para hacerlo, pero aprende observando sus errores, según lo determinado por la salida del detector de rostros".

El generador adversarial eventualmente llega a un punto en el que es capaz de engañar al detector de rostros casi 99 por ciento del tiempo.

Básicamente, los investigadores crearon un filtro similar a Instagram que se puede aplicar a las fotos para proteger la privacidad personal.

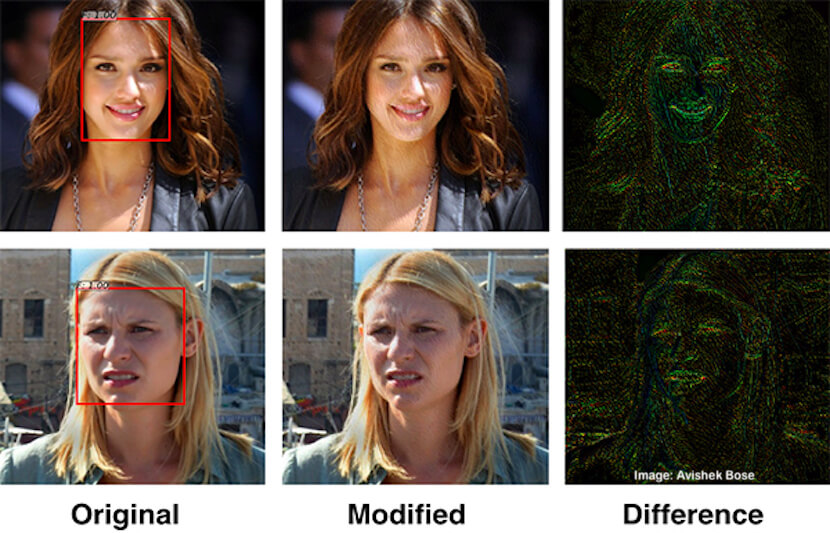

El nuevo algoritmo realiza ligeros cambios en los píxeles de una imagen que son imperceptibles para los humanos, pero capaces de engañar a un detector de rostro de última generación.

"La IA disruptiva puede 'atacar' lo que está buscando la red neuronal para la detección de rostros", dijo Bose en un comunicado. “Si la IA de detección está buscando la esquina de los ojos, por ejemplo, ajusta la esquina de los ojos para que sean menos visibles. Crea perturbaciones muy sutiles en la foto, pero para el detector son lo suficientemente importantes como para engañar al sistema ".

Los investigadores probaron su sistema en un grupo de caras 600, incluyendo diferentes etnias, entornos y condiciones de iluminación.

El sistema redujo efectivamente la cantidad de dispositivos de reconocimiento de caras que originalmente pudieron detectar desde casi 100 por ciento a solo 0.5 por ciento.

Además, la tecnología puede interrumpir la búsqueda basada en imágenes, la estimación étnica, la identificación de características, la emoción y cualquier otro atributo basado en la cara que pueda extraerse automáticamente.

Motivación

Este estudio fue provocado por el interés de Aarabi y Bose en investigar los modos de falla de los modernos algoritmos de detección y reconocimiento de rostros basados en el aprendizaje profundo.

"Inicialmente comenzamos probando estos algoritmos en condiciones extremas como desenfoque, brillo y oscuridad", dijo Bose.

A partir de sus experimentos, los investigadores notaron que incluso las imágenes en condiciones decentes podían causar ocasionalmente que fallaran los dispositivos, lo que conectaba bien con parte de la nueva literatura sobre ataques adversos, explicó Bose.

"Esencialmente, un ataque de confrontación provoca cambios pequeños y a menudo imperceptibles en la imagen de entrada, lo que hace que los modelos de aprendizaje automático fallen catastróficamente", dijo Bose.

"Este es un fenómeno conocido en muchos modelos de aprendizaje profundo, pero nunca se investigó en el contexto de los sistemas de detección / reconocimiento de rostros".

¿Qué es lo siguiente?

Aarabi y Bose desean extender este estilo de ataque a otras clases de detectores. Si bien esto puede ser difícil o imposible en algunos casos, el objetivo principal es comprender y caracterizar el concepto.

Una vez que los investigadores tengan éxito en el cumplimiento de esta tarea contra múltiples clases de detectores, se podría hacer una herramienta, pero aún están lejos de esto, dijo Bose.

"En el futuro, puede imaginar una aplicación que aplique este filtro de privacidad a sus fotos antes de cargarla en Internet", explicó.

Pero por el momento, todavía se debe investigar mucho.

"Nuestro artículo es solo el punto de partida en lugar de algo cercano al objetivo final", dijo Bose.

Bose desea señalar que, aunque los investigadores fueron capaces de engañar a un algoritmo de detección de la cara del estado de la técnica, todavía no afirman ser capaces de atacar a todos los dispositivos de detección de rostros.

"Este es un pequeño paso hacia un objetivo más amplio en el que facultamos al usuario para proteger su propia privacidad si así lo desean", dijo Bose.